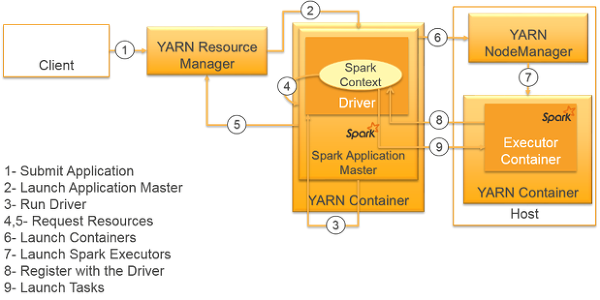

[yarn-cluster spark-submit]

[yarn-client spark-submit]

스파크는 spark-submit이라는 모든 클러스터 매니저 간에 작업을 제출해 주는 단일 툴을 제공한다. spark-submit이 옵션 없이 스크립트 이름 혹은 jar 파일 이름만으로 호출된다면 단순히 로컬로 스파크 프로그램을 실행한다.

이 프로그램을 스파크 단독 클러스터 매니저에게 제출하기 위해서는 단독 클러스터의 주소 및 실행을 원하는 익스큐터 프로세스의 크기 등 추가 정보를 제공해 주어야 한다.

ex) bin/spark-submit --master spark://host:7077 --executor-memory 10g test.py

| --master | 접속할 클러스터 매니저 |

| --deploy-mode | 드라이버 프로그램이 'client' or 'cluster'로 실행될지 결정. 기본은 client모드이다. |

| --class | java나 scala 프로그램 실행할 때 main 클래스를 지정 |

| --name | 어플리케이션 이름 지정. |

| --jar | 어플리케이션 path 지정 |

| --files | 애플리케이션의 작업 경로 내에 필요한 파일의 목록 |

| --py-files | 애플리케이션의 PYTHONPATH에 추가되어야 할 파일 목록이다. .py, .egg, .zip 파일 등이 가능하다. |

| --executor-memory | 익스큐터가 쓸 메모리를 바이트 단위로 지정. 512m, 15g 등으로 사용. |

| --driver-memory | 드라이버 프로세스가 쓸 메모리를 바이트 단위로 지정. 512m, 15g 등으로 사용. |

ex)

$ export HADOOP_CONF_DIR=/opt/hadoop/conf

$ ./bin/spark-submit \

--master yarn \

--class job.nclicks.parquet.DeviceLevelStatJob.class

--name "Spark_Batch" \

--queue dev \

--num-executors 40

--executor-memory 10g

Spark_Batch.jar

출처:https://12bme.tistory.com/441

[SPARK] 스파크 SUBMIT

[yarn-cluster spark-submit] [yarn-client spark-submit] 스파크는 spark-submit이라는 모든 클러스터 매니저 간에 작업을 제출해 주는 단일 툴을 제공한다. spark-submit이 옵션 없이 스크립트 이름 혹은 jar 파일 이름

12bme.tistory.com

'Spark' 카테고리의 다른 글

| Spark - 데이터 구조 - DataFrame (0) | 2024.05.14 |

|---|---|

| Spark - 데이터 구조 - RDD (0) | 2024.05.14 |

| Spark 구조 (1) | 2024.05.14 |

| Spark 란? (1) | 2024.05.14 |

| scala- SaveMode, StorageLevel (0) | 2024.04.09 |